ทำไม “ภาพถ่ายดาวเทียมความละเอียดสูง” ถึงไม่ได้แปลว่าจะเป็นภาพดีที่สุด?

จากกล้องถ่ายภาพบนดาวเทียมสู่ Image Processing และ AI ที่ภาพสวยอาจไม่เท่ากับ “ความจริง”

เวลาที่เราพูดถึงดาวเทียมถ่ายภาพแล้ว คำถามยอดฮิตคือ “ดาวเทียมถ่ายภาพดวงนี้มีความละเอียดเท่าไหร่ 50 เซน หรือ 1 เมตร?” ซึ่งหลายพวกเราหลาย ๆ คน รวมถึงผู้ที่อาจจะพอรู้เรื่องความละเอียดของภาพถ่ายดาวเทียมบ้างเล็กน้อย มักจะสรุปว่า ยิ่งความละเอียด (Resolution) สูง เช่น ต่ำกว่า 1 เมตร (หรือ Google Earth ที่เราเห็นคืออาจลงไปถึงระดับ 0.15 เมตร) ยิ่งดี แต่ในความเป็นจริงแล้ว คุณภาพของ Payload กล้องของดาวเทียม และความน่าเชื่อถือของภาพ อาจไม่ได้ตัดสินแค่ที่ตัวเลข Resolution เพียงอย่างเดียว

เพราะนอกจากตัวกล้องซึ่งหมายถึง Optics และ Detector แล้ว ภาพถ่ายจากดาวเทียมที่เราเห็นในทุกวันนี้ ยังผ่าน ขั้นตอนการประมวลผลภาพ (Image Processing) ที่ซับซ้อนขึ้นเรื่อย ๆ ตั้งแต่เทคนิคการถ่ายแบบ pushbroom และ pushframe ไปจนถึงการใช้ AI เข้ามาทำ Super-resolution ให้ภาพชัดมากขึ้นและลบเมฆให้ภาพดูสวยเนียนตาเหมือนกับแอพในสมาร์ทโฟนสมัยนี้ ที่สามารถลบคนหรือสิ่งของออกจากรูปได้ แต่มาพร้อมความเสี่ยงเรื่อง AI hallucination ที่อาจทำให้ข้อมูล “ผิด แต่ดูน่าเชื่อมาก” บทความนี้จึงอยากชวนผู้อ่านมารู้จักกับภาพถ่ายดาวเทียม “ให้ลึกกว่าความละเอียด” และตั้งคำถามกับภาพสวย ๆ ว่า“นี่คือภาพจริงจากเซนเซอร์…หรือเป็นภาพที่ถูก AI เติมจินตนาการเข้าไปแล้ว?”

1. Resolution บอกแค่ “ขนาดพิกเซล” ไม่ได้บอก “ความคมชัดจริงๆ ของภาพ”

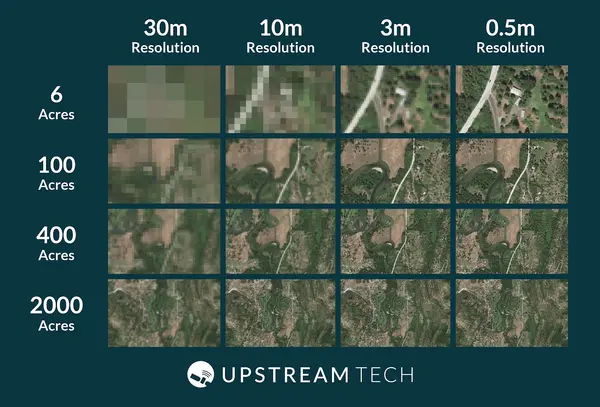

ตัวอย่างความชัดของภาพถ่ายดาวเทียมตาม Resoulution ต่าง ๆ

Resolution หรือ GSD (Ground Sampling Distance) คือขนาดพื้นที่บนพื้นดินที่หนึ่งพิกเซลแทนอยู่ เช่น 0.5 m, 1 m, 3 m เป็นต้น ซึ่งนั่นหมายความว่า ภาพถ่ายความละเอียด 0.5 m ก็คือ 1 พิกเซลของภาพนี้จะเท่ากับขนาดประมาณ 50×50 ซม. หรือหากเป็น 3 m ก็คือ 1 พิกเซลของภาพเท่ากับพื้นที่ 3×3 ม. พราะฉะนั้นยิ่งตัวเลขเล็ก เราเห็นรายละเอียดเล็ก ๆ ได้มากขึ้น

แต่จริง ๆ แล้ว ดาวเทียมสองดวงที่มีความละเอียดของภาพที่เขียนว่า 1 m เท่ากัน อาจให้ภาพที่มีความคมคนละเรื่องกันเลย เพราะยังอยู่กับอีกหลายปัจจัยดังนี้

- MTF (Modulation Transfer Function) คือ ความสามารถในการรักษาขอบและรายละเอียดเล็ก ๆ ให้มีความคมชัด

- SNR (Signal-to-Noise Ratio) คือ คุณภาพของภาพที่บอกว่าภาพนี้มีความใสหรือมีนอยส์เยอะ

- คุณภาพเลนส์และขนาดรูรับแสง (Aperture)

- ความนิ่งของดาวเทียมระหว่างถ่ายภาพ (Pointing Stability / Jitter)

ดังนั้น การบอกว่า ดาวเทียมความละเอียด 1 m ดีกว่า 2 m แน่นอน จึงเป็นการมองคุณภาพ Payload แค่ “ครึ่งเดียว” เท่านั้น

2. ภาพสีสวย ๆ เป็นแค่ “ชั้นผิว” ของข้อมูล เพราะ ประสิทธิภาพที่จริงอยู่ในแถบสเปกตรัม (Band) ของภาพ

ภาพที่คนทั่วไปคุ้นตา คือ ภาพสีเสมือนจริง (True Color) ที่ใช้แบนด์ Red–Green–Blue ใกล้เคียงสายตามนุษย์มาทำการผสมกัน ซึ่งเราก็จะเห็นเป็นภาพสีทั่วไปเหมือนกับกล้องถ่ายภาพสมาร์ทโฟน แต่สำหรับงานด้านความมั่นคงและการบรรเทาสาธารณภัยนั้น ข้อมูลที่สำคัญมักจะอยู่ในแบนด์ที่สายตาของคนนั้นมองไม่เห็น เช่น Near Infared, Short Wave Infared และ Thermal

2.1 Near Infared หรือ NIR คือ แบนด์ที่ใช้ประโยชน์ในการ ดูพืชพรรณ ความชื้น น้ำ และร่องรอยเปลี่ยนแปลง

- สามารถแยกพื้นที่พืชเขียวกับพื้นที่แห้งแล้งออกจากกัน

- ใช้ทำ Change Detection เช่น ร่องรอยของยานพาหนะบนทุ่งหญ้า การทำเส้นทางลำเลียง หรือพื้นที่ถูกถมใหม่

2.2 Short Wave Infared หรือ SWIR คือ แบนด์ที่สำคัญในการดูจุดความร้อน การทิ้งระเบิด ไฟป่า การซ่อนพราง ซึ่งมีความสามารถเด่นมากในการ “ดึงของที่ตาเปล่ามองไม่เห็นให้เด้งขึ้นมา” เช่น

- เห็น แนวไฟและ Hotspot ชัดแม้ภาพสีปกติจะเห็นแต่ควันหนาทึบ

- แยกพื้นที่ที่เพิ่งถูกเผาไหม้หรือระเบิดออกจากพื้นที่เดิมได้ชัด

- ช่วยตรวจจับการซ่อนพรางบางชนิด เพราะวัสดุพรางจะสะท้อน SWIR ไม่เหมือนสภาพแวดล้อม

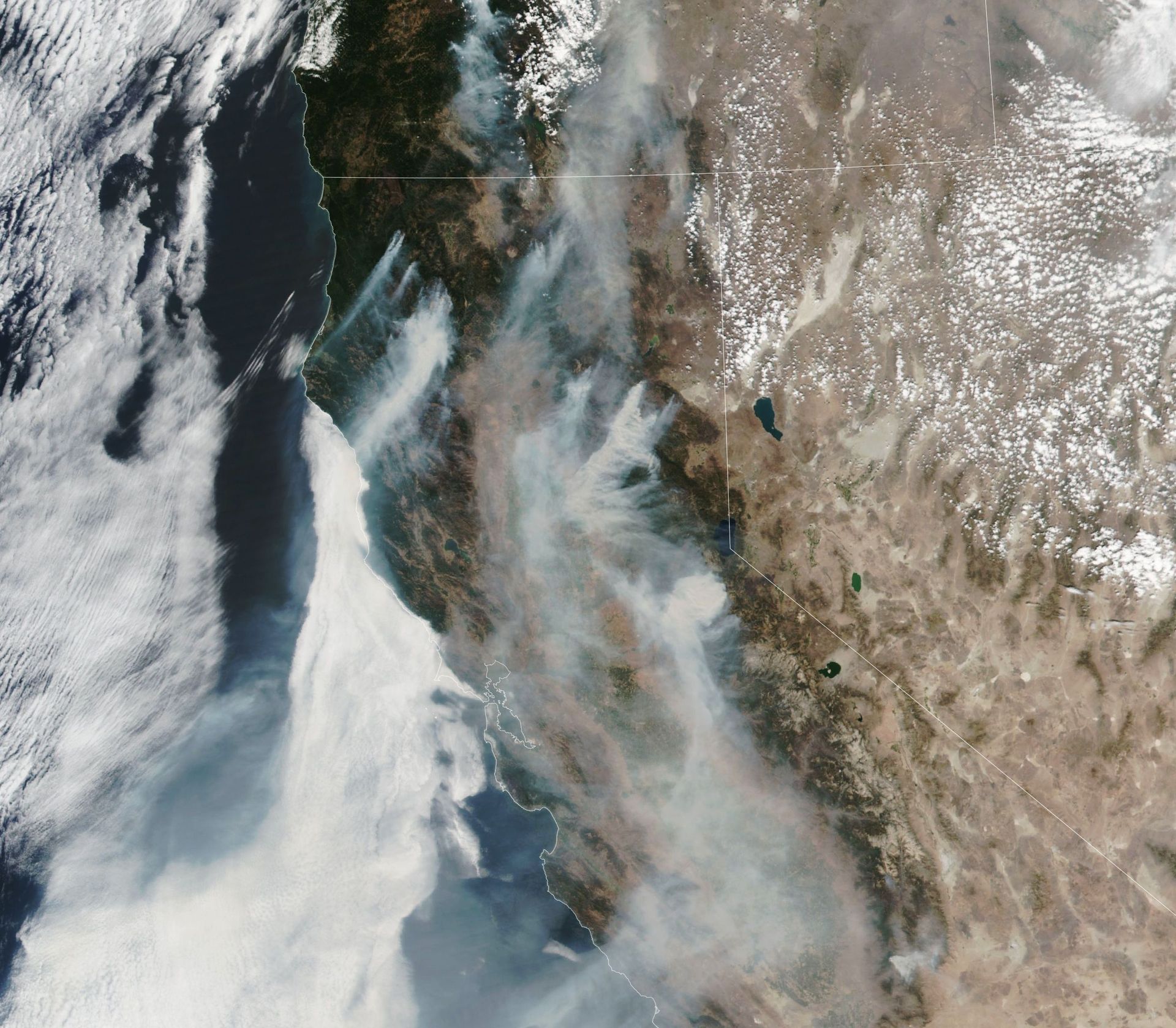

ตัวอย่างด้านล่างคือภาพไฟป่าที่ใช้ SWIR / NIR / แบนด์ต่าง ๆ ทำภาพสีเทียม เพื่อเน้นพื้นที่ไฟและพื้นที่เสียหายให้เด่นขึ้นจากพื้นหลัง

ภาพถ่ายดาวเทียม Landsat8 ในช่วงไฟป่าที่แคลิฟอร์เนีย โดยที่เป็นภาพแบบ True Colour หรือ RGB ทำให้ไม่สามารถมองเห็นจุดความร้อนได้ชัดเจน.

2.3 Thermal หรือ Mid Wave Infared (MWIR) คือ แบนด์ที่สามารถตรวจจับอุณหภูมิและเป้าหมายในเวลากลางคืนใช้ดูอุณหภูมิต่าง ๆ เช่น

- รถถังที่เพิ่งติดเครื่อง

- จุดความร้อนในคลังเชื้อเพลิงหรือคลังยุทธภัณฑ์

- ความเสียหายจากการโจมตีที่ยังร้อนอยู่

ข้อดีคือ

ทำงานได้เต็มที่แม้ในเวลากลางคืน แต่นี่คือแบนด์ภาพระดับ Premium ที่มักอยู่ในดาวเทียมถ่ายภาพระดับสูง ดังนั้นในหลายภารกิจ ภาพ Multispectral ความละเอียด 2–3 m ที่มี NIR SWIR Thermal

อาจสามารถให้ข้อมูลภาพเพิ่มจากภาพ PAN 0.5 m ที่มีแค่ช่องเดียวอย่างชัดเจน

3. ตั้งแต่ “การถ่ายภาพ” จนถึง “การประมวลผลภาพ” ภาพที่เห็น = ข้อมูลดิบ + คณิตศาสตร์ + AI

สิ่งที่คนมักลืมคือ ภาพถ่ายดาวเทียมหนึ่งภาพที่เราเห็น ไม่ใช่ข้อมูลดิบจากเซนเซอร์ตรง ๆ เพราะเบื้องหลังมีทั้ง “วิธีถ่ายภาพ” และ “ขั้นตอนการประมวลผล” ที่ส่งผลต่อความคม ความสวย และแน่นอน “ความเสี่ยงของการบิดเบือนข้อมูล”

3.1 เทคนิคการถ่ายภาพของดาวเทียมแบบ Pushbroom vs Pushframe – ถ่ายทีละเส้น กับถ่ายทีละเฟรม

กล้องดาวเทียมรุ่นใหม่จำนวนมากใช้เทคนิคการถ่ายภาพแบบ pushbroom ซึ่งเซนเซอร์เรียงภาพเป็น “เส้น ๆ ” ตั้งฉากกับทิศทางการโคจรของดาวเทียม ดังนั้นณะที่ดาวเทียมเคลื่อนที่ กล้องจะ “กวาด” ภาพทีละเส้น สะสมเป็นภาพแถวยาวเหมือนเอาไม้กวาดลากไปข้างหน้า อันเป็นที่มาของชื่อ pushbroom ซึ่งข้อดีคือดาวเทียมจะมีระยะเวลาที่สามารถหมุนกล้องไปยังเป้าหมายได้นาน (dwell time สูง) และเหมาะกับ multispectral / hyperspectral แต่ต้องอาศัย การปรับเทียบภาพ (Calibration) และการแก้การบิดเบี้ยวเชิงพื้นที่ (Geometric correction) ที่ดีมาก

สำหรับแนวคิดใหม่อย่าง “pushframe imaging” ใช้หลักคล้าย pushbroom แต่แทนที่จะถ่ายเป็นเส้น pushframe คือการถ่ายทีละเฟรมหลายครั้ง แล้วเอามาประกอบ และกู้ภาพกลับด้วยวิธีการทางคณิตศาสตร์ (Compressive sensing) เพื่อเพิ่ม SNR หรือคุณภาพภาพ รวมถึงเปิดทางให้เซนเซอร์แบบใหม่ ๆ ที่มีขนาดเล็กลงแต่ฉลาดขึ้นสามารถทำงานในอวกาศได้อย่างมีประสิทธิภาพ

3.2 Image Processing แบบทั่วไป คือการปรับให้ภาพถ่ายให้ “ใกล้ความจริง” มากขึ้น

โดยขั้นตอนมาตรฐานที่แทบทุกภาพถ่ายดาวเทียมต้องผ่าน เช่น

- Radiometric correction คือการปรับค่าสัญญาณภาพให้อยู่ในระดับที่ถูกต้องตามหลักฟิสิกส์ของแสง โดยมีเป้าหมายคือทำให้ ความเข้มของพิกเซล สะท้อนค่าพลังงานที่สะท้อนจากพื้นผิว ไม่ใช่ถูก บิดเบือนจากปัจจัยอื่น เช่น แสงอาทิตย์สว่างไม่เท่ากัน

- Geometric Correction คือการแก้ไขความบิดเบี้ยวทางเรขาคณิตของภาพ เพื่อให้ตำแหน่งบนภาพ ตรงกับตำแหน่งจริงบนพื้นโลก ซึ่งเกิดจากสาเหตุ เช่น มุมของการเอียงตัวถ่ายภาพ ความโค้งของโลก เป็นต้น นอกจากนี้ Geometric Correction ในขั้นสูง จะมีการพูดถึง Orthorectification ซึ่ง คือ การแก้ distortion ที่เกิดจากความสูงภูเขา หุบเขา โดยใช้ DEM เข้ามาแก้ไข

- Pan-sharpening คือเอาภาพ PAN (ความละเอียดสูง) มาผสมกับ Multispectral (หลายแบนด์แต่ความละเอียดต่ำกว่า) เพื่อให้ได้ภาพถ่ายดาวเทียมสีที่มีความละเอียดสูงที่ยังคงมีข้อมูลจาก Multispectral อยู่

- Ultra High Resolution Processing เป็นเทคนิคที่ใช้กับกล้องถ่ายภาพแบบ Pushframe ซึ่งเป็นการถ่ายรูปพื้นที่เดียวกันต่อเนื่องหลายเฟรมที่เหลื่อมตำแหน่งกันเล็กน้อยในระดับต่ำกว่าขนาดพิกเซล (sub-pixel) จากนั้นระบบจะนำภาพเหล่านี้มา ซ้อนและจัดตำแหน่งให้ตรงกันอย่างละเอียด เมื่อรวมข้อมูลจากหลายเฟรมเข้าด้วยกัน จึงสามารถดึงรายละเอียดเล็ก ๆ ที่เดิมถูกซ่อนอยู่ในขอบพิกเซลออกมาได้ โดยที่ทุกอย่างที่เห็นคือข้อมูลจริงที่ดาวเทียมเคยถ่ายได้อยู่แล้ว เพียงแต่ถูกดึงออกมาให้ชัดเจนกว่าภาพดิบเฟรมเดียวเท่านั้น

3.3 Image Processing ยุค AI – ภาพสวยขึ้น แต่มีโอกาสเกิด “ภาพหลอน”

ช่วงไม่กี่ปีที่ผ่านมา เริ่มมีการใช้ AI / Deep Learning ทำสิ่งที่เกินจากการ “ปรับภาพ” แบบเดิม เช่น การทำภาพแบบ Super-resolution ที่ทำให้ภาพ 1–2 m ให้มีความชัดระดับ 0.5 m หรือดีกว่านั้น การทำ Cloud removal ลบเมฆหรือจุดรบกวน แล้ววาดฉากหลัง “ให้ดูสมเหตุสมผล” คล้ายกับการใช้แอพลบภาพคนออกจากภาพถ่ายสมาร์ทโฟนในปัจจุบัน

ปัญหาคือ AI ไม่ได้ “รู้” ว่าสิ่งที่สร้างขึ้นมีอยู่จริงหรือไม่ แต่มัน “เดา” จากรูปแบบของข้อมูลที่เคยฝึกมา ซึ่งงานวิจัยด้าน Super-resolution เองก็เตือนว่า มีความเสี่ยงที่โมเดลจะ “แต่งหรือสร้างภาพหลอก” (hallucinate) และจะเพิ่มข้อมูลที่ผิดสูงมาก เช่น เติมถนน อาคาร หรือเส้นขอบวัตถุที่ไม่เคยมีจริงในภาพดิบต้นฉบับ โดยในเชิงปฏิบัติ เราอาจเจอสถานการณ์แบบนี้ เช่น ภาพถูก AI ทำให้คมชัดขึ้น ทำให้เห็นเหมือนมี เสาอากาศ รถคันเล็ก หรือ ประตู หน้าต่างเพิ่มขึ้นมาทั้งที่ภาพดิบเป็นรอยเบลอ หรือแม้กระทั่ง ระบบลบเมฆแล้วเติมพื้นหลัง ที่ดูเนียนมาก แต่พื้นหลังเป็น ภาพที่เดาจากสถิติ ไม่ใช่สถานการณ์จริงในวันนั้น

สำหรับงานด้านการทหารและความมั่นคงที่ต้องได้รับการ นี่คือ จุดที่มีความเสี่ยงเป็นอย่างมาก เพราะเป็นภาพที่มีความละเอียดที่ดีขึ้น แต่ผู้ใช้ปลายทางมักจะไม่รู้ว่าภาพผ่าน AI อะไรมาบ้าง และอาจทำให้เกิดการตัดสินใจผิดจากข้อมูลภาพที่ถูกสร้างขึ้นจาก AI ดังนั้น

ภาพสวย = ไม่เท่ากับ ภาพจริง

ภาพคม = ไม่เท่ากับ ข้อมูลถูกต้อง

เพราะฉะนั้นเราจึงต้องจัดการ AI-based processing ในฐานะเครื่องมือช่วยตีความ และไม่ใช่เครื่องมือสร้างความจริงใหม่ ซึ่งสำหรับงานด้านความมั่นคงและการป้องกันและบรรเทาสาธารณภัย การใช้ภาพดาวเทียมในยุคที่ AI เข้าไปแต่งภาพได้เก่งขึ้นเรื่อย ๆ ควรมีหลักคิดอย่างน้อย 4 ข้อ

1. แยกให้ชัดเจนระหว่าง “ภาพดิบ/ภาพมาตรฐาน” กับ ภาพ AI-enhanced ซึ่งในการตัดสินใจที่สำคัญควรดูภาพที่ผ่านการประมวลผลมาตรฐานที่ไม่ใช้ AI ควบคู่กับภาพ AI-enhanced เสมอ

2. บันทึก processing chain ทุกครั้ง โดยระบุให้ชัดว่าภาพผ่านขั้นตอนอะไรบ้าง ใช้โมเดล AI ตัวไหน ทำ Super-resolution กี่เท่า ลบเมฆหรือไม่

3. ใช้ AI เป็นผู้ช่วย ไม่ใช่ผู้ตัดสิน เพราะ AI สามารถช่วยชี้จุดน่าสนใจ แต่การฟันธงต้องวนกลับมาที่ข้อมูลต้นฉบับ และแหล่งข้อมูลที่สำคัญอื่น เช่น SIGINT HUMINT และการวิเคราะห์ของมนุษย์

ท้ายที่สุดนี้ เมื่อพูดถึง “คุณภาพของกล้องดาวเทียม” เราไม่ควรถามแค่ “ดาวเทียมมีความชัดกี่เมตร?”

แต่ควรถามต่อว่า

- ภาพคมจริงไหม? (ดูจาก MTF, SNR)

- มีกี่แบนด์ อะไรบ้าง? (PAN, RGB, NIR, SWIR, Thermal)

- ใช้วิธีถ่ายแบบไหน (pushbroom / pushframe) และต้องแก้ distortion อย่างไร?

- ผ่าน Image Processing อะไรมาบ้าง เป็นแบบมาตรฐาน หรือ AI-enhanced?

- มีโอกาสเกิด AI hallucination หรือไม่ และเรารู้ข้อจำกัดแค่ไหน?

เพราะสำหรับงานด้านความมั่นคง และการบรรเทาสาธารณภัย ภาพที่ดีที่สุด ไม่ใช่ภาพที่ สวยที่สุด แต่คือภาพที่ ตรงกับความจริงมากที่สุด และรู้ชัดว่าผ่านการประมวลผลแบบไหนมาแล้วบ้าง

แหล่งอ้างอิง :

https://www.upstream.tech/posts/2020-03-03-the-view-from-above

บทความโดย

น.ต.ณัฐดนัย วิศิษฏ์โยธิน